回归方程E(Y)=β0+β1X的参数β0,β1的最小二乘估计与最大似然估计在什么条件下等价?给出证明。

回归方程E(Y)=β0+β1X的参数β0,β1的最小二乘估计与最大似然估计在什么条件下等价?给出证明。

题目解答

答案

解析

本题考察最小二乘估计与最大似然估计等价的条件及证明,关键在于利用正态分布假设下的最大似然函数推导,并对比最小二乘估计的目标函数。

核心知识点

- 最小二乘估计(LS):通过最小化残差平方和 $Q = \sum_{i=1}^n (Y_i - \hat{Y}_i)^2$ 估计参数,不要求误差分布假设。

- 最大似然估计(MLE):通过最大化似然函数估计参数,需假设误差分布。

等价条件及证明

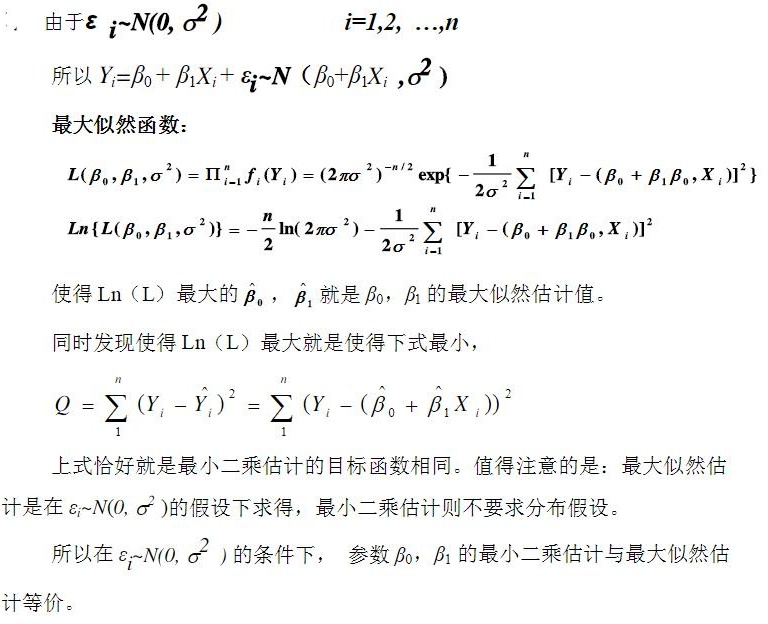

条件:误差项 $\varepsilon_i \sim N(0, \sigma^2)$(独立同分布正态误差)。

步骤1:似然函数构建

因 $Y_i = \beta_0 + \beta_1 X_i + \varepsilon_i$,且 $\varepsilon_i \sim N(0, \sigma^2)$,故 $Y_i \sim N(\beta_0 + \beta_1 X_i, \sigma^2)$。

似然函数为各 $Y_i$ 的密度乘积:

$L(\beta_0, \beta_1, \sigma^2) = \prod_{i=1}^n \frac{1}{\sqrt{2\pi\sigma^2}} \exp\left(-\frac{(Y_i - \beta_0 - \beta_1 X_i)^2}{2\sigma^2}\right)$

取对数得对数似然函数:

$\ln L = -\frac{n}{2}\ln(2\pi\sigma^2) - \frac{1}{2\sigma^2}\sum_{i=1}^n (Y_i - \beta_0 - \beta_1 X_i)^2$

步骤2:最大化对数似然函数

对数似然函数中,$\sigma^2$ 为常数时,最大化 $\ln L$ 等价于最小化:

$Q = \sum_{i=1}^n (Y_i - \beta_0 - \beta_1 X_i)^2$

这正是最小二乘估计的目标函数!因此,最大化似然函数与最小化残差平方和等价,故 $\beta_0, \beta_1$ 的MLE与LS估计相同。

关键对比

- MLE依赖 $\varepsilon_i \sim N(0, \sigma^2)$ 的分布假设;

- LS估计仅需残差平方和最小,无分布限制。